Lo último que nos falta es un entorno que nos permita explotar eficientemente toda la información almacenada en ElasticSearch, con este fin vamos a proceder con la instalación de Kibana.

Empezamos descargando desde la web oficial de Elastic la versión correspondiente:

|

1 |

> wget https://download.elastic.co/kibana/kibana/kibana_4.5.4_amd64.deb |

Instalamos el paquete con el siguiente comando:

|

1 |

> sudo dpkg -i kibana_4.5.4_amd64.deb |

Como resultado nos encontraremos Kibana instalado en /opt/kibana , el archivo de configuración en /opt/kibana/config/kigana.yml y el script de arranque en /etc/init.d/kibana .

Como ElasticSearch tiene la configuración por defecto y está instalado en el mismo servidor, no tenemos que configurar nada y podemos ejecutar Kibana sin problemas:

|

1 2 3 4 5 6 7 8 9 10 11 |

sudo sudo /opt/kibana/bin/kibana log [18:04:02.502] [info][status][plugin:kibana] Status changed from uninitialized to green - Ready log [18:04:02.556] [info][status][plugin:elasticsearch] Status changed from uninitialized to yellow - Waiting for Elasticsearch log [18:04:02.583] [info][status][plugin:kbn_vislib_vis_types] Status changed from uninitialized to green - Ready log [18:04:02.597] [info][status][plugin:markdown_vis] Status changed from uninitialized to green - Ready log [18:04:02.617] [info][status][plugin:metric_vis] Status changed from uninitialized to green - Ready log [18:04:02.634] [info][status][plugin:spyModes] Status changed from uninitialized to green - Ready log [18:04:02.662] [info][status][plugin:statusPage] Status changed from uninitialized to green - Ready log [18:04:02.691] [info][status][plugin:table_vis] Status changed from uninitialized to green - Ready log [18:04:02.713] [info][status][plugin:elasticsearch] Status changed from yellow to green - Kibana index ready log [18:04:02.719] [info][listening] Server running at http://0.0.0.0:5601 |

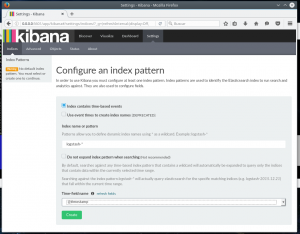

Podemos ver que Kibana ya está funcionado y escuchando en el puerto 5601, así que procederemos a acceder desde nuestro explorador favorito a http://localhost:5601 :

Una vez en este paso, aceptaremos los valores por defecto, ya que solo tendremos un índice creado (todos los que empiezan por «logstash-«) y solo tenemos un campo de tipo fecha (@timestamp). Solo le tendremos que dar al botón CREATE.

Pero antes de seguir profundizando en Kibana y ahora que hemos comprobado que está funcionando correctamente, vamos a detener la ejecución e instalarlo como servicio en el arranque del sistema:

|

1 |

> sudo systemctl start kibana |

Ahora, reiniciamos la máquina y comprobamos que Kibana ha arrancado correctamente accediendo a servicio web anteriormente mencionado.

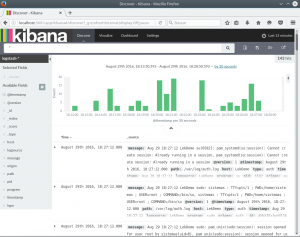

Ya tenemos todo el entorno ELK funcionando correctamente, solo nos falta definir correctamente los filtros en Logstash y realizar algunas pruebas sobre cómo crear consultas, vistas y dashboard dentro de Kibana, que lo explicaremos en el próximos articulos.

Referencias de interés: